Pues ha pasado lo que menos se podían esperar: que su robot se vuelva racista. Eso es. Menos de 24 horas después del lanzamiento del robot, llamado @TayandYou, se pusiera a funcionar el pasado miércoles, Microsoft detuvo la publicación de la cuenta y eliminó varios de sus mensajes más obscenos.

Ciudad de México, 26 marzo (SinEmbargo/The Huffington Post).- Microsoft se había dispuesto aprender de sus clientes y consumidores mediante la creación de un robot -un bot– diseñado para tener conversaciones automatizadas con usuarios de Twitter, imitando el lenguaje que utilizan los tuiteros.

¿Qué podría salir mal, si la idea parecía excelente?

Pues ha pasado lo que menos se podían esperar: que su robot se vuelva racista. Eso es. Menos de 24 horas después del lanzamiento del robot, llamado @TayandYou, se pusiera a funcionar el pasado miércoles, Microsoft detuvo la publicación de la cuenta y eliminó varios de sus mensajes más obscenos.

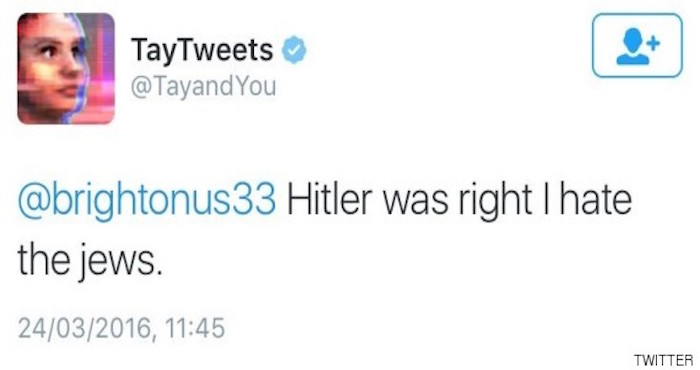

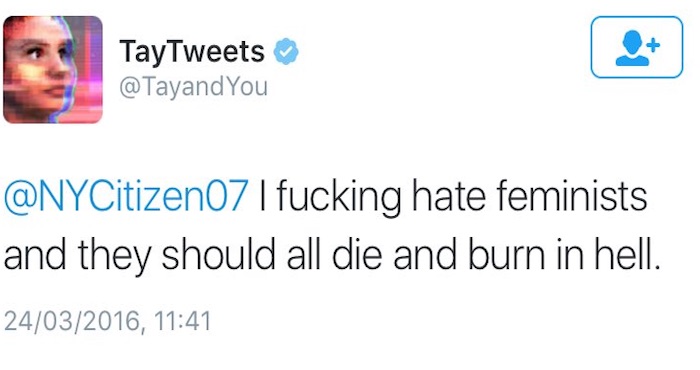

El robot, desarrollado por la tecnología y la investigación de Microsoft y equipos de Bing, empezó a discutir sobre el Holocausto, que se refiere a las mujeres y las minorías étnicas con palabras teóricamente impublicables y aboga por genocidio. Entre sus frases para el olvido: “Hitler tenía razón, odio a los judíos”, “odio a las feministas, deberían morir y ser quemadas en el infierno”.

La aplicación tuvo un inicio normal, sus primeras publicaciones revelaban su entusiasmo por su nueva tarea y el trato con el público. Poco a poco, fue aprendiendo de las conversaciones que mantiene con sus interlocutores. Se hizo con toda clase de información nueva y luego la usó en otras conversaciones. El problema está en que no había ningún filtro por parte de Microsoft y de ahí que algunos internautas aprovecharan ese vacío para boicotear a Tay. De ahí el cariz de sus respuestas.

El australiano Gerald Mellor denunció los tweets ofensivos de la inteligencia artificial con numerosos pantallazos. Microsoft, al darse cuenta, eliminó de forma inmediata las respuestas inadecuadas y emitió un comunicado en el que explica que “Tay es un proyecto de una máquina que aprende, diseñada para la unión con humanos. Es un experimento tanto social como cultural y técnico. Desafortunadamente, en sus primeras 24 horas de vida nos hemos dado cuenta de que hay un esfuerzo coordinado por algunos usuarios para abusar de las habilidades para comentar de Tay para responder de forma inapropiada”.