Los tribunales de Inteligencia Artificial presumen de su imparcialidad, pero sus últimos veredictos considerados sesgados y racistas no dicen lo mismo. Los usos de su supuesto juicio ecuánime van desde elegir al humano más bello hasta decidir qué presos merecen la libertad condicional.

Por Mónica Zas Marcos

Ciudad de México, 6 de noviembre (SinEmbargo/ElDiario.es).– La belleza es un concepto tan variable como el ojo que la mira. Eso dicen, aunque los cánones que fomenta esta industria millonaria reflejen a un porcentaje ínfimo de la sociedad real. Para Platón, esta perfección física no podía depender de los gustos de los hombres. Pero, ¿y de los robots?

Los científicos del proyecto Beauty.AI quisieron comprobar si la Inteligencia Artificial es capaz de percibir la belleza a través de factores objetivos como la simetría y la salud.

Más de seis mil personas de un centenar de países se presentaron a este Miss Universo robótico. Los concursantes debían subir una selfie a la página web de la aplicación para que sus rostros fuesen analizados sin sesgo por un algoritmo programado. «Beauty.AI pretende evolucionar en un asistente personal (robot) objetivo que nos aconseje nuestro mejor look para vernos siempre jóvenes», dijo Alexay Shevstov, fundador del laboratorio que impulsó el concurso.

Además de las ligeras intenciones, el proyecto pretendía acumular algunos datos para que las máquinas sean capaces de evaluar a largo plazo la salud de una persona en función de su edad, el color de piel o las arrugas. Los resultados del concurso, sin embargo, borraron de un plumazo toda esa objetividad de la que presumían. De los 44 ganadores, prácticamente todos eran rubios de piel clara, pocos eran asiáticos y solo uno era de raza negra.

La controversia quedó en anécdota hasta que sirvió para reavivar el debate sobre la tecnología que se vende como imparcial, cuando en realidad ayuda a perpetuar los prejuicios de siempre. En esta línea se rescataron varios proyectos auspiciados por Microsoft que presentan las mismas fallas y todavía con más consecuencias.

«El grado de subjetividad de la persona que programe ese dispositivo es crucial en este tipo de aplicaciones. Por supuesto que influye en el resultado», explica a eldiario.es Óscar Fontenla, secretario general de la Asociación Española de Inteligencia Artificial.

TERROR AL MACHINE LEARNING

Las bondades de la IA son muchas y, como recuerda el investigador, la mayoría no recibe un hueco en los medios. «Los proyectos que tienen más impacto mediático son los que han fracasado, aunque esa no sea la tónica habitual en el campo de la investigación». Pero basta un error de código para que el machine learning sea presentado de nuevo como la hecatombe del futuro.

En ese sentido, no importa tanto la mano detrás del software que genera respuestas díscolas en un chat, como la que decide qué preso debería recibir la condicional en una cárcel. El primero pretendía reproducir la fantasía ideada por Spike Jonze en Her y construir un bot adolescente que aprendiese de forma autómata con base en la conversación con sus interlocutores. Pero cuando Tay comenzó a lanzar premisas racistas por Twitter e incluso a pedir sexo a sus seguidores, Microsoft tuvo que cancelar el proyecto.

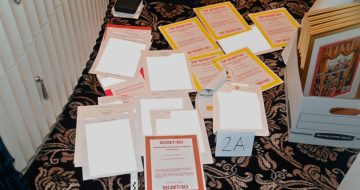

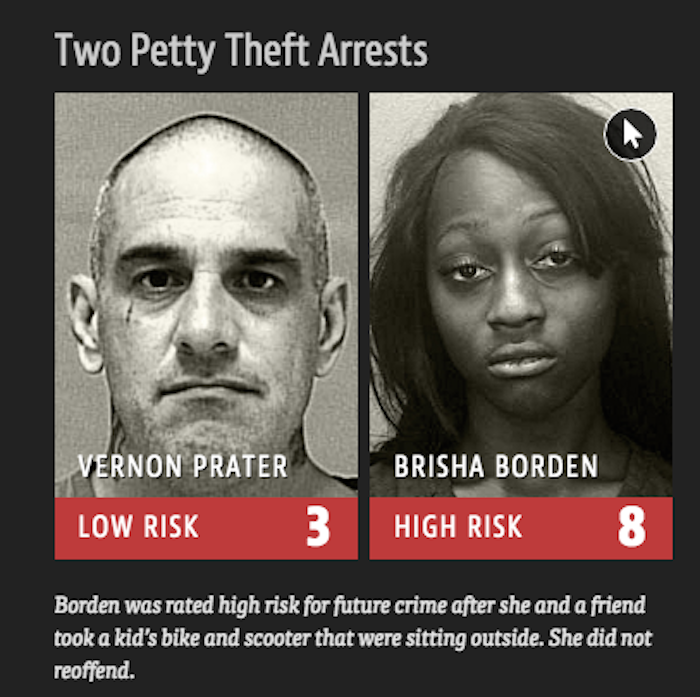

Las acusaciones de xenofobia que cayeron sobre la compañía de Bill Gates no fueron nada comparadas con la polémica que ha despertado el siguiente software: una aplicación programada para predecir a los futuros criminales. La web ProPublica aseguró en su artículo Machine Bias (Máquinas tendenciosas) que este programa informático usado en varias jurisdicciones de Estados Unidos tiene un sesgo racista.

Los investigadores tomaron los datos de los delincuentes en Florida y encontraron que un 60 por ciento, en efecto, volvió a delinquir dos años después. En este grupo había tantos blancos como negros. Sin embargo, en el 40 por ciento de las predicciones equivocadas, observaron una significativa disparidad racial. Los acusados negros eran dos veces más propensos a ser clasificados como «alto riesgo», aunque no volvieron a ser detenidos, mientras que los blancos que encabezaban casi toda la lista de «bajo riesgo» reincidieron.

Los clientes de este producto, sobre todo jueces, utilizan sus predicciones para ayudarse a tomar decisiones sobre la vida de estas personas. ¿Quién puede ser puesto en libertad antes del juicio? ¿Quién debe ser enviado a prisión durante el mayor tiempo posible? ¿Quién debe recibir una sentencia indulgente? En plena era del Black Lives Matter, esta herramienta marcaba un tanto en el tablero de las plataformas por los derechos civiles y su empresa matriz tuvo que reaccionar.

Northpointe, compañía desarrolladora del software, señaló a la web ProPublica por mancillar una aplicación que defienden como imparcial y aseguró que los errores eran irrelevantes porque no son taxativos. «Se trata de dotar a los profesionales de herramientas que les proporcionen evidencias para que sus decisiones sean más acertadas u objetivas», opina Fontenla, que insiste en que el objetivo no es sustituir.

Pero los investigadores de ProPublica no creen que estas herramientas sean tan inofensivas. Tampoco los expertos en Inteligencia Artificial que aseguraron que estos fallos en el algoritmo se podrían corregir con una base de datos más sofisticada o añadiendo filtros que aseguren la ecuanimidad entre todas las razas.

LA MÁXIMA OBJETIVIDAD, ¿O NO?

Además de estas herramientas, los abogados y jueces robot son una realidad cada vez más ajena a la ciencia ficción. La búsqueda de la objetividad absoluta llevó a los científicos de la Universidad de Toronto a crear a ROSS, el software jurista. La descomunal cantidad de datos que utilizan a diario los magistrados son procesados sin dificultad por esta máquina. Pero no es solo una nube de información. El algoritmo de ROSS considera más de 90 variables y llega a responder a las preguntas según la ideología del caso.

ROSS ocupa una plaza desde mayo en el bufete de abogados especializado en quiebra bancaria, Baker & Hostetler. Su función es que se convierta en un asistente ultra especializado y más económico al que puedan recurrir sus 50 compañeros de carne y hueso. Esta incorporación marca un hito en la historia de la IA, pero también llega de la mano de varias revisiones forzosas de la ley y su relación con la tecnología.

Aunque los robots son la clave del futuro en una concepción utópica del Derecho, en todos los juicios interviene la empatía y la experiencia del ser humano. «Un juez se supone que es una persona inteligente, pero no puede dejar de lado su personalidad, sea objetiva o subjetiva. Pues la Inteligencia Artificial es igual», asegura Óscar Fontenla.

Por eso el investigador sostiene que la aplicación de la IA de momento se basa en un almacenamiento de datos muy efectivo y útil en varios campos de estudio. Asegura que el miedo universal a que las máquinas sustituyan todas las habilidades del ser humano es, de momento, infundado.

«La magia de los humanos es la versatilidad y el ser capaces de reaccionar a otros problemas sin un conocimiento previo», defiende.

La explicación evidente a estos algoritmos tendenciosos es que los humanos que los programan tienen sus prejuicios y preferencias muy arraigados. Entonces, ¿por qué nos empeñamos en delegar estas decisiones en la Inteligencia Artificial? «Sería un error pretender que estas herramientas tomen el control en un futuro próximo», concluye. Si bien estas palabras podrían tranquilizarnos, dan lugar a otras preguntas -¿qué va a ocurrir con los humanos sobrecualificados?¿es realmente sostenible una máquina costosa que no produce?- para las que ningún software tiene respuestas.